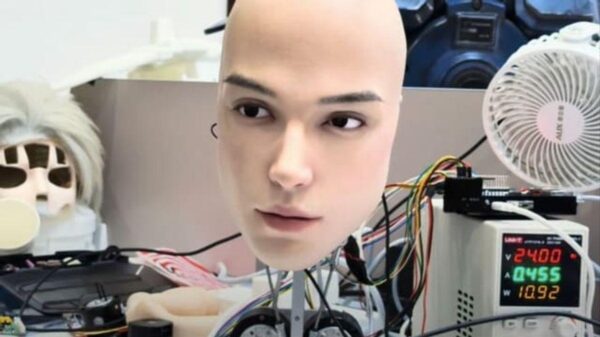

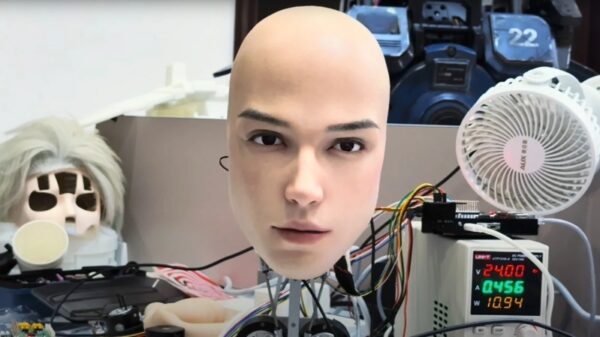

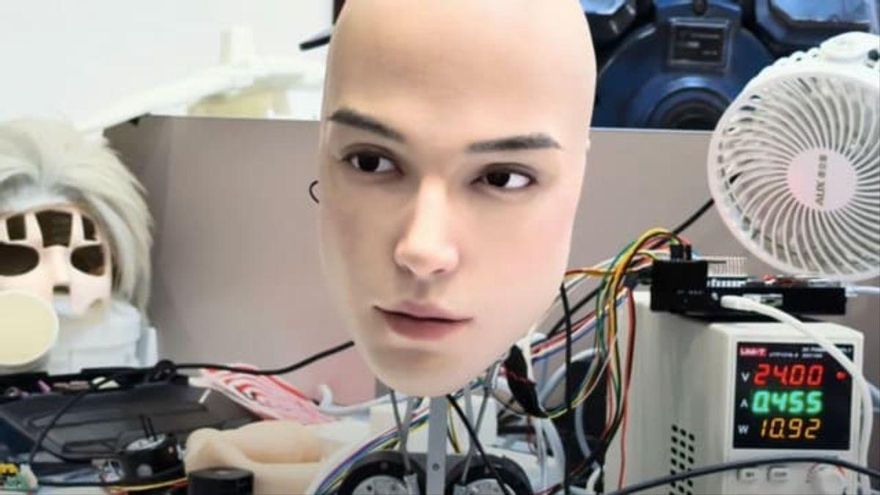

Una innovadora cabeza de robot humanoide desarrollada en China ha llamado la atención por su capacidad para exhibir expresiones faciales que imitan la realidad. Este avance, realizado por AheadForm, busca transformar la interacción entre humanos y robots.

Un video que se volvió viral en las redes sociales presenta al robot parpadeando, inclinando la cabeza y mostrando sutilezas en su rostro que han sido descritas como “inquietantes”. Según Futurism, este despliegue ha provocado una mezcla de admiración y temor entre los usuarios, quienes han hecho comparaciones con obras de ciencia ficción.

AheadForm explica en su página web que sus cabezas robóticas cuentan con motores de alta precisión y un diseño que permite múltiples grados de libertad. Esto facilita el control de cejas, párpados, labios y microexpresiones de la piel sintética. Además, el robot está equipado con sensores visuales y de audio que le permiten percibir su entorno y reaccionar en tiempo real.

Las capacidades de este robot, sustentadas en un modelo de inteligencia artificial, le permiten “expresar emociones auténticas y crear expresiones faciales realistas”. Esto abre un nuevo horizonte para interacciones más naturales entre humanos y máquinas, según los desarrolladores.

El prototipo utiliza decenas de micromotores para generar pequeños gestos, así como cámaras integradas en los ojos para el seguimiento visual. Un artículo de Live Science menciona que las posibles aplicaciones de esta tecnología incluyen atención al cliente, educación y cuidado de la salud, donde la empatía percibida podría facilitar la comunicación.

A pesar de los avances técnicos, surgen interrogantes éticos y psicológicos. Expertos en robótica advierten sobre el “valle inquietante”, un fenómeno donde los robots que se asemejan demasiado a los humanos pueden resultar perturbadores para las personas.

Otras compañías, como Shanghai Qingbao Engine Robot, también han desarrollado androides realistas que se utilizan en diversos entornos públicos, incluyendo exposiciones, tiendas y hospitales. Sin embargo, la falta de transparencia en la interacción con estas máquinas plantea dudas sobre si los usuarios podrán identificar cuándo están tratando con un ser programado para simular emociones.

Por último, el debate se extiende al ámbito laboral. A medida que empresas como AheadForm exploran la integración de modelos de lenguaje y visión, surge la pregunta de si el enfoque debe ser la sustitución de tareas humanas o el diseño de herramientas que complementen y respeten la dignidad de las personas.